浏览代码

Localizing kr (#2356)

Localizing kr (#2356)

* add kor ver of README.md and empty docs, images * add Installation.md translated to korean * Fixed main readme docs and move all the English documents in the docs folder * modify contents of 'Installation.md' and add kr version 'Installation-Windows.md'(not completed) with related image * completed 1st translation of 'Installation-Windows.md' and added related images for korean docs * add kr version 'Using-Docker.md'(not completed) * translate Training-PPO.md to Korean * Change word about epsilon in Training-PPO.md * Fix Training PPO about epsilon * completed korean translation of 'Using-Docker.md' * Training Imitation Learning translation to Korean is finished! Also information about the translators are added * modified all 'blogs.unity3d.com/' to 'blogs.unity3d.com/kr' * removed all non-translated doc * add translator information/develop-generalizationTraining-TrainerController

当前提交

14c9b2fc

共有 52 个文件被更改,包括 14217 次插入 和 5310 次删除

-

71docs/localized/KR/README.md

-

629docs/localized/KR/docs/images/academy.png

-

221docs/localized/KR/docs/images/agent.png

-

204docs/localized/KR/docs/images/brain.png

-

355docs/localized/KR/docs/images/broadcast.png

-

999docs/localized/KR/docs/images/crawler.png

-

577docs/localized/KR/docs/images/cuDNN_membership_required.png

-

181docs/localized/KR/docs/images/cuda_toolkit_directory.PNG

-

178docs/localized/KR/docs/images/cudnn_zip_files.PNG

-

999docs/localized/KR/docs/images/mlagents-3DBallHierarchy.png

-

277docs/localized/KR/docs/images/mlagents-NewProject.png

-

200docs/localized/KR/docs/images/mlagents-NewTutAcademy.png

-

999docs/localized/KR/docs/images/mlagents-NewTutAssignBrain.png

-

502docs/localized/KR/docs/images/mlagents-NewTutBlock.png

-

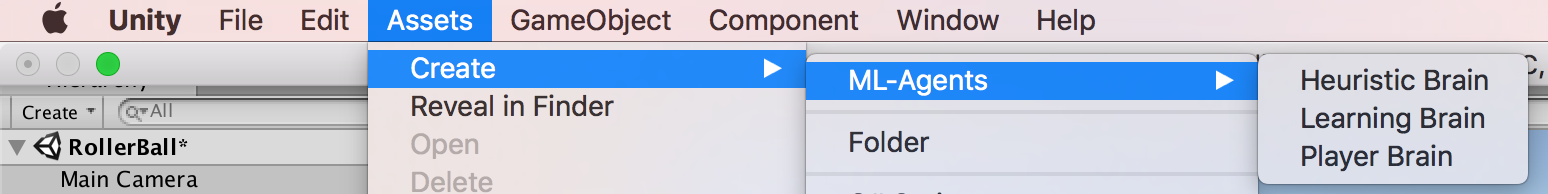

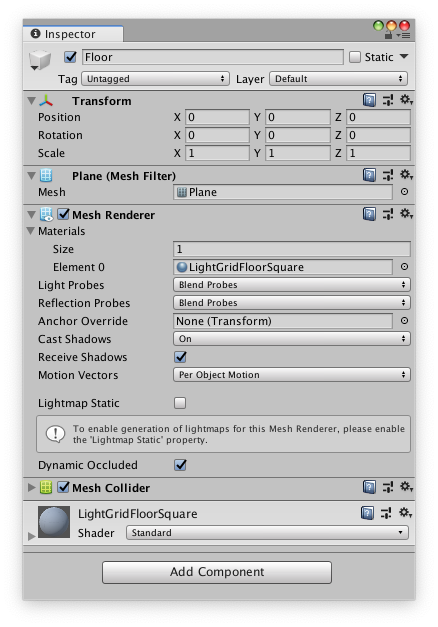

703docs/localized/KR/docs/images/mlagents-NewTutBrain.png

-

536docs/localized/KR/docs/images/mlagents-NewTutFloor.png

-

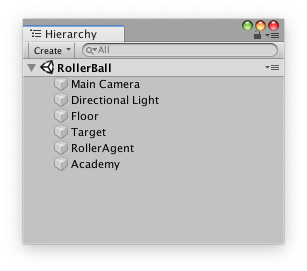

132docs/localized/KR/docs/images/mlagents-NewTutHierarchy.png

-

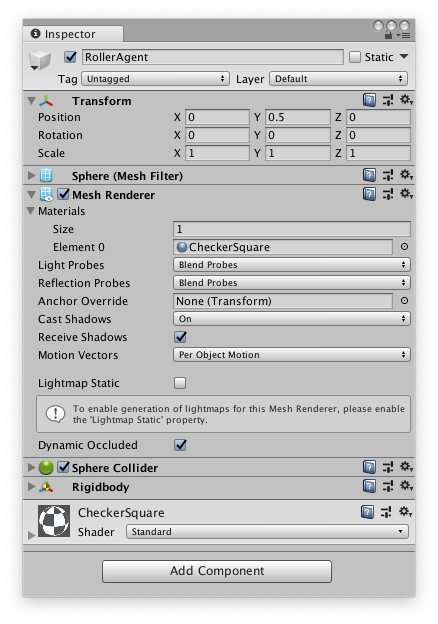

507docs/localized/KR/docs/images/mlagents-NewTutSphere.png

-

819docs/localized/KR/docs/images/mlagents-NewTutSplash.png

-

999docs/localized/KR/docs/images/mlagents-Open3DBall.png

-

701docs/localized/KR/docs/images/mlagents-TensorBoard.png

-

218docs/localized/KR/docs/images/new_system_variable.PNG

-

127docs/localized/KR/docs/images/path_variables.PNG

-

47docs/localized/KR/docs/images/system_variable_name_value.PNG

-

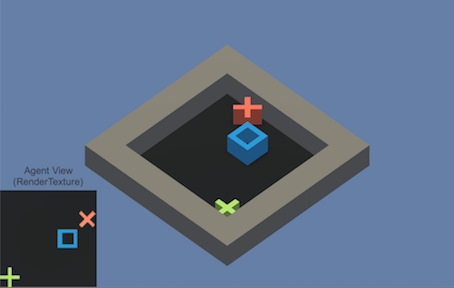

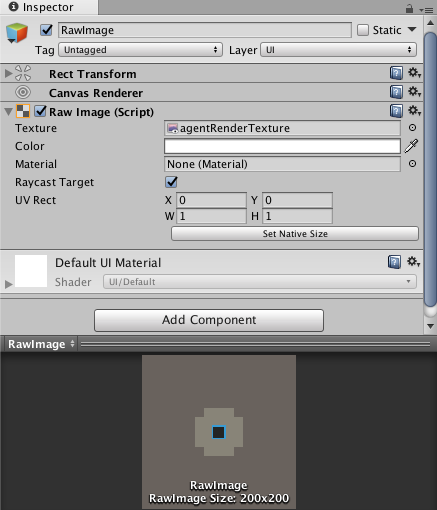

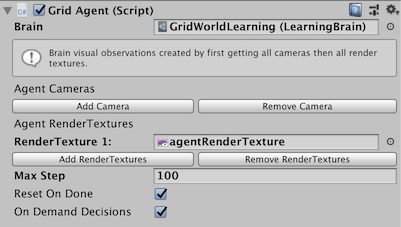

302docs/localized/KR/docs/images/visual-observation.png

-

304docs/localized/KR/docs/Installation-Windows.md

-

104docs/localized/KR/docs/Installation.md

-

85docs/localized/KR/docs/Training-Imitation-Learning.md

-

151docs/localized/KR/docs/Training-PPO.md

-

123docs/localized/KR/docs/Using-Docker.md

-

196docs/localized/KR/docs/images/3dball_learning_brain.png

-

497docs/localized/KR/docs/images/3dballhard.png

-

1001docs/localized/KR/docs/images/bananaimitation.png

-

96docs/localized/KR/docs/images/demo_component.png

-

223docs/localized/KR/docs/images/demo_inspector.png

-

23docs/localized/KR/docs/images/edit_env_var_kr.png

-

1001docs/localized/KR/docs/images/image-banner.png

-

292docs/localized/KR/docs/images/mlagents-RollerAgentStats.png

-

243docs/localized/KR/docs/images/mlagents-SetBrainToTrain.png

-

55docs/localized/KR/docs/images/new_system_variable_kr.PNG

-

28docs/localized/KR/docs/images/path_variables_kr.PNG

-

196docs/localized/KR/docs/images/platform_prefab.png

-

648docs/localized/KR/docs/images/pyramids.png

-

1001docs/localized/KR/docs/images/running-a-pretrained-model.gif

-

20docs/localized/KR/docs/images/system_variable_name_value_kr.PNG

-

151docs/localized/KR/docs/images/visual-observation-combination.png

-

272docs/localized/KR/docs/images/visual-observation-debug.png

-

166docs/localized/KR/docs/images/visual-observation-rawimage.png

-

167docs/localized/KR/docs/images/visual-observation-rendertexture.png

-

1001docs/localized/KR/docs/images/walker.png

-

0docs/localized/KR/docs/Migrating.md

-

0docs/localized/KR/docs/Readme.md

999

docs/localized/KR/docs/images/crawler.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

999

docs/localized/KR/docs/images/mlagents-3DBallHierarchy.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

999

docs/localized/KR/docs/images/mlagents-NewTutAssignBrain.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

999

docs/localized/KR/docs/images/mlagents-Open3DBall.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

218

docs/localized/KR/docs/images/new_system_variable.PNG

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

|

|||

# Windows �����ڸ� ���� ML-Agents Toolkit ��ġ ���� |

|||

|

|||

ML-Agents toolkit�� Windows 10�� �����մϴ�. �ٸ� ������ Windows ���ε� ML-Agents toolkit�� |

|||

������ �� ������ �������� �ʾҽ��ϴ�. ����, ML-Agents toolkit�� Windows VM(Bootcamp �Ǵ� ���� ó�� |

|||

ȯ�� ����)�� ���� ���� �������� �ʾҽ��ϴ� . |

|||

|

|||

ML-Agents toolkit�� �����ϱ� ����, �Ʒ��� �����Ȱ� ó�� Python�� �䱸�Ǵ� Python ��Ű���� ��ġ�ؾ� �մϴ�. |

|||

�� ���̵��� ���� GPU ���� �н�(�����ڸ� ����)�� ���� ���� ������ �ٷ��ϴ�. |

|||

����, ML-Agents toolkit�� ���� GPU ���� �н��� �ʿ����� ������ ���� ���� �Ǵ� Ư�� ���� �ʿ��� �� �ֽ��ϴ�. |

|||

|

|||

## �ܰ� 1: Anaconda�� ���� Python ��ġ |

|||

|

|||

Windows ������ Anaconda�� [�ٿ��ε�](https://www.anaconda.com/download/#windows)�ϰ� ��ġ�Ͻʽÿ�. |

|||

Anaconda�� ���������ν�, �ٸ� ���� ������ Python�� �и��� ȯ�濡�� ������ �� �ֽ��ϴ�. |

|||

Python 2�� ���̻� �������� �ʱ� ������ Python 3.5 �Ǵ� 3.6�� �ʿ��մϴ�. �� ���̵忡�� �츮�� |

|||

Python 3.6 ������ Anaconda 5.1 ������ ������ ���Դϴ�. |

|||

([64-bit](https://repo.continuum.io/archive/Anaconda3-5.1.0-Windows-x86_64.exe) |

|||

�Ǵ� [32-bit](https://repo.continuum.io/archive/Anaconda3-5.1.0-Windows-x86.exe) |

|||

��ũ). |

|||

|

|||

<p align="center"> |

|||

<img src="images/anaconda_install.PNG" |

|||

alt="Anaconda Install" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

����Ʈ _advanced installation options_�� �����ϴ� ���� ��õ������ ��Ȳ�� ���� ������ �ɼ��� �����Ͻʽÿ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/anaconda_default.PNG" alt="Anaconda Install" width="500" border="10" /> |

|||

</p> |

|||

|

|||

��ġ �Ŀ� �ݵ��� __Anaconda Navigator__ �� ���� ������ �Ϸ��ؾ� �մϴ�. |

|||

Windows Ž�� â����, _anaconda navigator_ �� Ÿ�����Ͽ� Anaconda Navigator �� �� �� �ֽ��ϴ�. |

|||

|

|||

ȯ�� ������ �����Ǿ����� �ʴٸ� `conda` ���ɾ Ÿ�������� �� |

|||

"conda is not recognized as internal or external command" ���� ������ ���� ���Դϴ�. |

|||

�̸� �ذ��ϱ� ���� ��Ȯ�� ȯ�� ���� ������ �ʿ��մϴ�. |

|||

|

|||

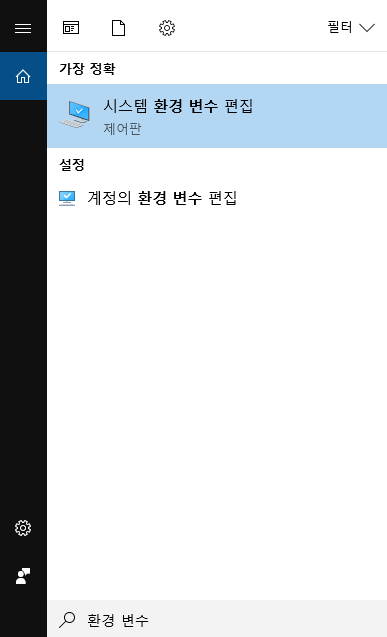

Ž�� â���� `ȯ�� ����`�� Ÿ���� �Ͽ� (������ Ű�� �����ų� ���� �Ʒ� ������ ��ư�� ���� �� �� �ֽ��ϴ�). |

|||

__�ý��� ȯ�� ���� ����__ �ɼ��� �ҷ��ɴϴ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/edit_env_var_kr.png" |

|||

alt="edit env variables" |

|||

width="250" border="10" /> |

|||

</p> |

|||

|

|||

�� �ɼǿ��� __ȯ�� ����__ ��ư�� Ŭ���ϰ�. �Ʒ� __�ý��� ����__���� "Path" ������ ���� Ŭ���ϰ� __���� ������__�� Ŭ���Ͽ� ���� �� path�� �߰��Ͻʽÿ�. |

|||

|

|||

```console |

|||

%UserProfile%\Anaconda3\Scripts |

|||

%UserProfile%\Anaconda3\Scripts\conda.exe |

|||

%UserProfile%\Anaconda3 |

|||

%UserProfile%\Anaconda3\python.exe |

|||

``` |

|||

|

|||

## �ܰ� 2: ���ο� Conda ȯ�� ���� �� Ȱ��ȭ |

|||

|

|||

ML-Agents toolkit�� �Բ� ������ ���ο� [Conda ȯ��](https://conda.io/docs/)�� ���� ���Դϴ�. |

|||

�� �۾��� ��ġ�� ���� ��Ű���� �� ȯ�濡�� ���ѵȴٴ� ���� �ǹ��մϴ�. �̴� �ٸ� ȯ���̳� �ٸ� ���̽� ��ġ�� |

|||

������ ��ġ�� �ʽ��ϴ�. ML-Agents�� ������ ������ �� Conda ȯ���� Ȱ��ȭ ���Ѿ� �մϴ�. |

|||

|

|||

���ο� Conda ȯ���� ������ ����, ���ο� Anaconda ������Ʈ(Ž�� â���� _Anaconda Prompt_�� Ŭ��)�� ���� ���� |

|||

���ɾ Ÿ���� �Ͻʽÿ�: |

|||

|

|||

```sh |

|||

conda create -n ml-agents python=3.6 |

|||

``` |

|||

|

|||

�� ��Ű���� ��ġ�ϱ� ���� ������ ���� ���� `y`�� Ÿ�����ϰ� ���� �����ʽÿ� _(���ͳ��� �����Ǿ��ִ��� Ȯ���Ͻʽÿ�)_. |

|||

�� �䱸�Ǵ� ��Ű������ �ݵ��� ��ġ�ؾ� �մϴ�. ���ο� Conda ȯ�濡�� Python 3.6 ������ �����Ǹ� ml-agents�� ȣ���˴ϴ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/conda_new.PNG" alt="Anaconda Install" width="500" border="10" /> |

|||

</p> |

|||

|

|||

�ռ� ���� ȯ���� �̿��ϱ� ���� �ݵ��� Ȱ��ȭ�� �ؾ��մϴ�. _(���Ŀ� ���� ���ɾ� ���� ȯ���� �������� �� �ֽ��ϴ�)_. |

|||

���� Anaconda ������Ʈ���� ���� ���ɾ Ÿ���� �Ͻʽÿ�: |

|||

|

|||

```sh |

|||

activate ml-agents |

|||

``` |

|||

|

|||

Ȱ��ȭ �Ŀ� `(ml-agents)`���� ���ڰ� ������ �� �տ� ��Ÿ���� ���� �� �� �ֽ��ϴ�. |

|||

|

|||

��������, `tensorflow`�� ��ġ�մϴ�. ���̽� ��Ű���� ��ġ�ϱ� ���� �����ϴ� `pip`���� ��Ű�� ���� �ý��۸� �����Ͽ� ��ġ�� �� �ֽ��ϴ�. |

|||

�ֽ� ������ TensorFlow�� �۵����� ���� �� �����Ƿ�, ��ġ ������ 1.7.1���� Ȯ���ؾ� �մϴ�. ���� Anaconda ������Ʈ â���� |

|||

���� ���ɾ Ÿ���� �Ͻʽÿ�._(���ͳ��� �����Ǿ� �ִ��� Ȯ���Ͽ� �ֽʽÿ�)_: |

|||

|

|||

```sh |

|||

pip install tensorflow==1.7.1 |

|||

``` |

|||

|

|||

## �ܰ� 3: �ʼ� ���̽� ��Ű�� ��ġ |

|||

|

|||

ML-Agents toolkit�� ���� ���̽� ��Ű���� �������Դϴ�. `pip`�� �����Ͽ� �� ���̽� ���Ӽ����� ��ġ�Ͻʽÿ�. |

|||

|

|||

ML-Agents Toolkit ������ �����Ұ� ���� ��ǻ�Ϳ� �����Ǿ����� �ʾҴٸ� �����Ͻʽÿ�. Git�� ([�ٿ��ε�](https://git-scm.com/download/win))�ϰ� |

|||

������Ų �� ���� ���ɾ Anaconda ������Ʈâ�� �Է��Ͽ� ������ �� �ֽ��ϴ�. _(���� �� ������Ʈ â�� �����ִٸ� `activate ml-agents`�� Ÿ�����Ͽ� |

|||

ml-agents Conda ȯ���� Ȱ��ȭ �Ǿ��ִ��� Ȯ���Ͻʽÿ�)_: |

|||

|

|||

```sh |

|||

git clone https://github.com/Unity-Technologies/ml-agents.git |

|||

``` |

|||

|

|||

���� Git�� �����ϰ� ���� �ʴٸ� ������ [��ũ](https://github.com/Unity-Technologies/ml-agents/archive/master.zip)���� ���� ������ �ٿ��ε� �� �� �ֽ��ϴ�. |

|||

|

|||

`UnitySDK` ���� �����丮���� ������Ʈ�� �߰��� ����Ƽ �ּ��� ���ԵǾ� �ֽ��ϴ�. ���� �����ϴµ� ������ �Ǵ� ���� [���� ȯ��](Learning-Environment-Examples.md)���� �ֽ��ϴ�. |

|||

|

|||

`ml-agents` ���� �����丮���� ����Ƽ ȯ���� �� �����ϴ� ���� ��ȭ�н� Ʈ���̳� ���̽� ��Ű���� ���ԵǾ� �ֽ��ϴ�. |

|||

|

|||

`ml-agents-envs` ���� �����丮���� `ml-agents` ��Ű���� ���ӵǴ� ����Ƽ�� �������̽��� ���� ���̽� API�� ���ԵǾ� �ֽ��ϴ�. |

|||

|

|||

`gym-unity` ���� �����丮���� OpenAI Gym�� �������̽��� ���� ��Ű���� ���ԵǾ� �ֽ��ϴ�. |

|||

|

|||

`mlagents-learn`�� ������ �� Ʈ���̳��� ȯ�� ���� ������ �� �����丮 �ȿ� �ʿ��ϹǷ�, ������ �ٿ��ε� �� �����丮�� ��ġ�� �����Ͻʽÿ�. |

|||

���ͳ��� �����Ǿ����� Ȯ���ϰ� Anaconda ������Ʈ���� ���� ���ɾ Ÿ���� �Ͻʽÿ�t: |

|||

|

|||

```console |

|||

pip install mlagents |

|||

``` |

|||

|

|||

ML-Agents toolkit�� ������ �� �ʿ��� ���� ���̽� ��Ű���� ��ġ�� �Ϸ��� ���Դϴ�. |

|||

|

|||

Windows���� ���� pip�� �����Ͽ� Ư�� ���̽� ��Ű���� ��ġ�� �� ��Ű���� ij���� �д� ���� ���� ���� �ֽ��ϴ�. |

|||

������ ���� ������ �ذ��� �� �� �ֽ��ϴ�: |

|||

|

|||

```console |

|||

pip install mlagents --no-cache-dir |

|||

``` |

|||

|

|||

`--no-cache-dir`�� pip���� ij���� ��Ȱ��ȭ �Ѵٴ� ���Դϴ�. |

|||

|

|||

|

|||

### ������ ���� ��ġ |

|||

|

|||

���� `ml-agents` �Ǵ� `ml-agents-envs`�� �����ϰ� �ʹٸ�, PyPi�� �ƴ� ������ �����ҷ� ���� ��Ű���� ��ġ�ؾ� �մϴ�. |

|||

�̸� ����, `ml-agents` �� `ml-agents-envs` �� ���� ��ġ�ؾ� �մϴ�. |

|||

|

|||

�������� ������ `C:\Downloads`�� ��ġ�� �ֽ��ϴ�. ������ �����ϰų� �ٿ��ε��� �� |

|||

Anaconda ������Ʈ���� ml-agents �����丮 ���� ml-agents ���� �����丮�� �����Ͻʽÿ�: |

|||

|

|||

```console |

|||

cd C:\Downloads\ml-agents |

|||

``` |

|||

|

|||

�������� ���� �����丮���� ������ �����Ͻʽÿ�: |

|||

|

|||

```console |

|||

cd ml-agents-envs |

|||

pip install -e . |

|||

cd .. |

|||

cd ml-agents |

|||

pip install -e . |

|||

``` |

|||

|

|||

`-e` �÷��� �����Ͽ� pip�� ���� �ϸ� ���̽� ������ ���� ������ �� �ְ� `mlagents-learn`�� ������ �� �ݿ��˴ϴ�. |

|||

`mlagents` ��Ű���� `mlagents_envs`�� �������̰�, �ٸ� ������ ��ġ�ϸ� PyPi�� ���� `mlagents_envs` �� ��ġ�� �� �ֱ� ������ |

|||

�� �������� ��Ű���� ��ġ�ϴ� ���� �߿��մϴ�. |

|||

|

|||

## (�ɼ�) Step 4: ML-Agents Toolkit�� ������ GPU �н� |

|||

|

|||

ML-Agents toolkit�� ���� GPU�� �ʿ����� ������ �н� �߿� PPO �˰����� �ӵ��� ũ�� ������ ���մϴ�(������ ���Ŀ� GPU�� ������ �� �� �ֽ��ϴ�). |

|||

�� ���̵��� GPU�� ������ �н��� �ϰ� ���� ���� �����ڸ� ���� ���̵� �Դϴ�. ���� GPU�� CUDA�� ȣȯ�Ǵ��� Ȯ���ؾ� �մϴ�. |

|||

[����](https://developer.nvidia.com/cuda-gpus) Nvidia ���������� Ȯ���� �ֽʽÿ�. |

|||

|

|||

���� ML-Agents toolkit �� CUDA 9.0 ������ cuDNN 7.0.5 ������ �����˴ϴ�. |

|||

|

|||

### Nvidia CUDA toolkit ��ġ |

|||

|

|||

Nvidia ��ī�̺꿡�� CUDA ��Ŷ(toolkit) 9.0�� [�ٿ��ε�](https://developer.nvidia.com/cuda-toolkit-archive)�ϰ� ��ġ�Ͻʽÿ�. |

|||

ML-Agents toolkit�� ������Ű�� ���� CUDA ��Ŷ�� GPU ���� ���̺귯��, |

|||

������-����ȭ ����, C/C++(���־� ��Ʃ���� 2017) �����Ϸ�, ��Ÿ�� ���̺귯���� �����մϴ�. |

|||

�� ���̵忡���� [9.0.176](https://developer.nvidia.com/compute/cuda/9.0/Prod/network_installers/cuda_9.0.176_win10_network-exe))������ �����մϴ�. |

|||

|

|||

��ġ�ϱ� ��, __���� ���� ����Ƽ �Ǵ� ���־� ��Ʃ������ �����ߴ���__ Ȯ���Ͽ� �ֽʽÿ�. |

|||

|

|||

�ν��緯�� �����ϰ� Express �ɼ��� �����Ͻʽÿ�. CUDA ��Ŷ�� ��ġ�� �����丮�� ������ �ֽʽÿ�. �� ���̵忡����, |

|||

`C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.0` ���ο� ��ġ�մϴ�. |

|||

|

|||

### Nvidia cuDNN ���̺귯�� ��ġ |

|||

|

|||

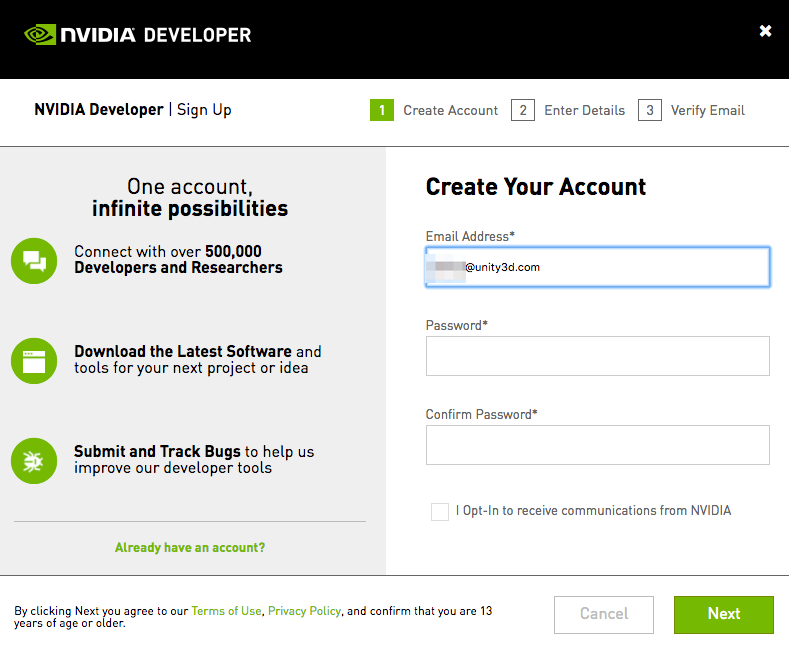

Nvidia���� cuDNN ���̺귯���� [�ٿ��ε�](https://developer.nvidia.com/cudnn)�ϰ� ��ġ�Ͻʽÿ�. |

|||

cuDNN�� ���� �Ű����� ���� �⺻�� �Ǵ� GPU ���� ���̺귯��. �ٿ��ε� ���� Nvidia Developer Program�� �����ؾ��� ���Դϴ�(����). |

|||

|

|||

<p align="center"> |

|||

<img src="images/cuDNN_membership_required.png" |

|||

alt="cuDNN membership required" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

�����ϰ� cuDNN [�ٿ��ε� ������](https://developer.nvidia.com/cudnn)�� ���ư��ʽÿ�. |

|||

ª�� �������翡 �����ؾ� �� ���� �ֽ��ϴ�. When you get to the list |

|||

cuDNN ������ ����Ʈ���� __�ܰ� 1���� ��ġ�� CUDA ��Ŷ�� �´� ������ �ٿ��ε��ϰ� �ִ��� Ȯ���Ͻʽÿ�.__ �� ���̵忡����, |

|||

CUDA ��Ŷ 9.0 ������ ���� 7.0.5 ������ �����մϴ� |

|||

([�ٿ��ε� ��ũ](https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.5/prod/9.0_20171129/cudnn-9.0-windows10-x64-v7)). |

|||

|

|||

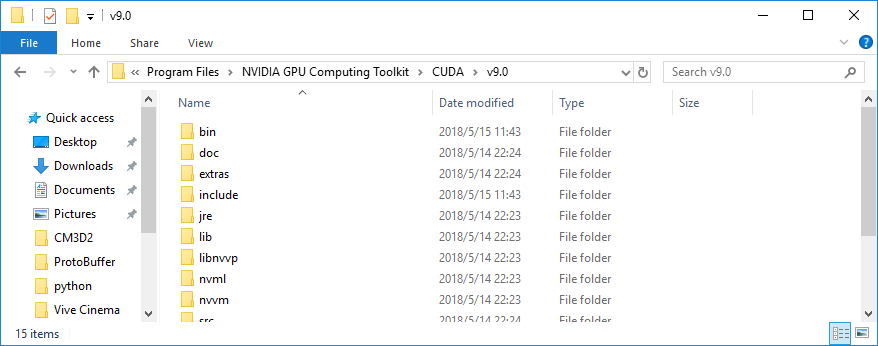

cuDNN ������ �ٿ��ε� �� �Ŀ�, CUDA ��Ŷ �����丮�ȿ� ������ ����(���� ����)�ؾ� �մϴ�. |

|||

cuDNN zip ���� �ȿ��� ������ ���� `bin`, `include`, ���� `lib`�� �ֽ��ϴ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/cudnn_zip_files.PNG" |

|||

alt="cuDNN zip files" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

�� ������ ������ CUDA ��Ŷ �����丮�ȿ� �����Ͻʽÿ�. |

|||

CUDA ��Ŷ �����丮�� `C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.0`�� ��ġ�� �ֽ��ϴ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/cuda_toolkit_directory.PNG" |

|||

alt="cuda toolkit directory" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

### ȯ�� ���� ���� |

|||

|

|||

1���� ȯ�� ������ 2���� ���� ������ �߰��ؾ� �մϴ�. |

|||

|

|||

ȯ�� ������ �����ϱ� ����, Ž�� â���� `ȯ�� ����`�� Ÿ���� �Ͽ� (������ Ű�� �����ų� ���� �Ʒ� ������ ��ư�� ���� �� �� �ֽ��ϴ�). |

|||

__�ý��� ȯ�� ���� ����__ �ɼ��� �ҷ��ɴϴ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/edit_env_var_kr.png" |

|||

alt="edit env variables" |

|||

width="250" border="10" /> |

|||

</p> |

|||

|

|||

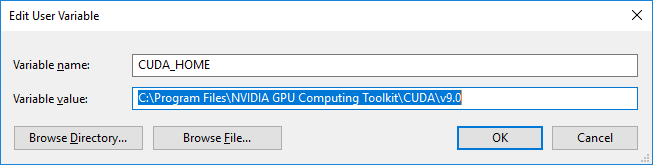

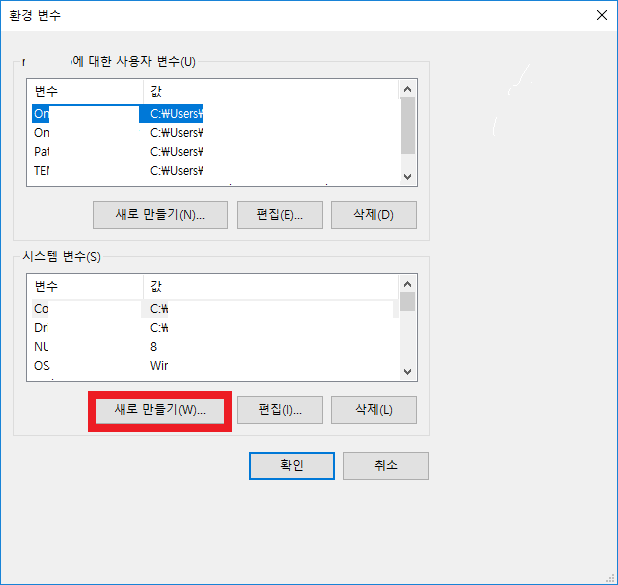

�� �ɼǿ��� __ȯ�� ����__ ��ư�� Ŭ���ϰ� �ý��� ������ __���� ������__�� Ŭ���Ͻʽÿ� _(������ ������ �ƴ� �Ʒ��� __�ý��� ����__���� Ȯ���Ͻʽÿ�). |

|||

|

|||

<p align="center"> |

|||

<img src="images/new_system_variable_kr.PNG" |

|||

alt="new system variable" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

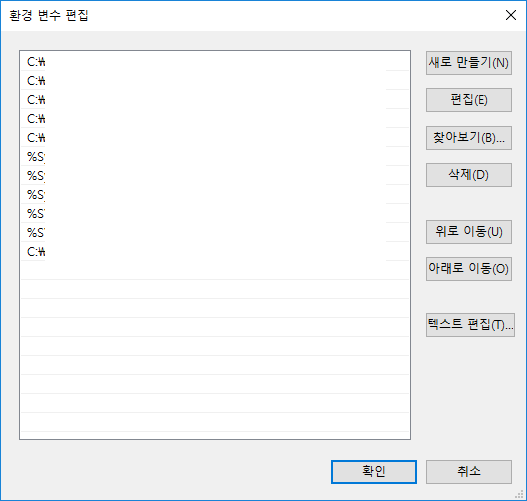

__���� �̸�__�� `CUDA_HOME`���� �����ϰ� ���� ������ CUDA ��Ŷ �����丮 ���θ� �Է��� �ֽʽÿ�. |

|||

�� ���̵忡�� �����丮 ���δ� `C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.0` �Դϴ�. Ȯ�� ��ư�� �����ֽʽÿ�. |

|||

|

|||

<p align="center"> |

|||

<img src="images/system_variable_name_value_kr.PNG" |

|||

alt="system variable names and values" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

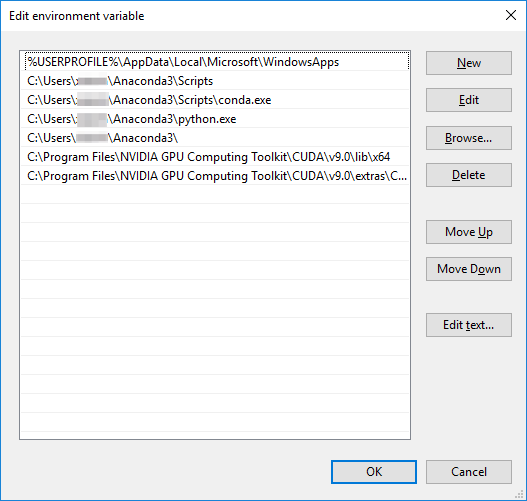

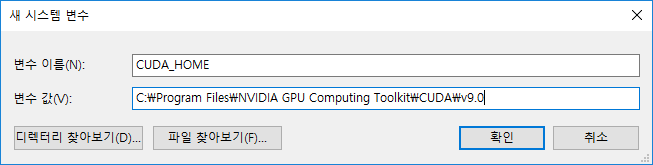

2���� ���� ���� ������ ���� __ȯ�� ����__ â ���� �Ʒ� �ι�° �ڽ��� __�ý��� ����__�ȿ���, |

|||

`Path` ������ ã�� Ŭ���ϰ� __����__��ư�� �����ʽÿ�. ����Ʈ�� 2���� �����丮�� �߰��� ���Դϴ�. �� �����丮�� ������ �����ϴ�: |

|||

|

|||

```console |

|||

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.0\lib\x64 |

|||

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.0\extras\CUPTI\libx64 |

|||

``` |

|||

|

|||

���� �����丮 ��ġ�� ��ġ�� �����丮 �������� Ȯ���Ͻʽÿ�. _���ҹ��ڿ� �����Ͻʽÿ�_. |

|||

|

|||

<p align="center"> |

|||

<img src="images/path_variables_kr.PNG" |

|||

alt="Path variables" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

### TensorFlow GPU ��ġ |

|||

|

|||

����, `pip`�� �����Ͽ� 1.7.1. ���� `tensorflow-gpu`�� ��ġ�Ͻʽÿ� . ml-agents Conda ȯ���� Ȱ��ȭ ��Ų Anaconda ������Ʈ���� |

|||

CPU�� TensorFlow �����ϰ� GPU�� TensorFlow�� ��ġ�ϱ� ���� ���� ���ɾ Ÿ���� �Ͻʽÿ� _(���ͳ��� �����Ǿ� �ִ��� Ȯ���Ͻʽÿ�)_: |

|||

|

|||

```sh |

|||

pip uninstall tensorflow |

|||

pip install tensorflow-gpu==1.7.1 |

|||

``` |

|||

|

|||

����������, ���� ���� ������ ��ġ�Ǿ� �ְ�, Tensorflow���� GPU�� �ν��ϰ� �ִ��� ��Ʈ�ؾ��մϴ�. |

|||

���� Anaconda ������Ʈ���� Python�� ȣ���Ͽ� ���ϴ�: |

|||

|

|||

```sh |

|||

python |

|||

``` |

|||

|

|||

���� ���� ���ɾ Ÿ���� �Ͻʽÿ�: |

|||

|

|||

```python |

|||

import tensorflow as tf |

|||

|

|||

sess = tf.Session(config=tf.ConfigProto(log_device_placement=True)) |

|||

``` |

|||

|

|||

������ ������ ������ �� �� ���� ���Դϴ�: |

|||

|

|||

```console |

|||

Found device 0 with properties ... |

|||

``` |

|||

|

|||

## Acknowledgments |

|||

|

|||

�� ���̵带 ������ ���� ������ �ʾ��� �ۼ��� |

|||

[Jason Weimann](https://unity3d.college/2017/10/25/machine-learning-in-unity3d-setting-up-the-environment-tensorflow-for-agentml-on-windows-10/) |

|||

�� |

|||

[Nitish S. Mutha](http://blog.nitishmutha.com/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html) |

|||

���� �����帳�ϴ�. |

|||

|

|||

## �ѱ� ���� |

|||

|

|||

�ش� ������ �ѱ� ������ [������ (Hyeonjun Jang)]([https://github.com/janghyeonjun](https://github.com/janghyeonjun))�� ���� �����Ǿ����ϴ�. ������ ������ ��Ż�ڰ� �ִ� ���� totok682@naver.com ���� �����ֽø� �����帮�ڽ��ϴ�. |

|||

|

|||

# 설치 |

|||

|

|||

ML-Agents를 설치하고 사용하기 위해 유니티를 설치해야 하고 이 Repository(저장소)를 |

|||

Clone(복제)하고 추가종속성을 가지는 Python(파이썬)을 설치해야합니다. 아래 Subsection(하위섹션)에서는 Docker(도커) 설정 외에도 |

|||

각 단계를 개괄적으로 설명합니다. |

|||

|

|||

## **Unity 2017.4** 또는 이후의 버전을 설치하십시오. |

|||

|

|||

[다운로드](https://store.unity.com/kr/download)하고 설치하십시오. 만약 저희의 도커 설정(차후에 소개할)을 사용하고 싶다면, |

|||

유니티를 설치할 때, Linux Build Support를 설정하십시오. |

|||

|

|||

<p align="center"> |

|||

<img src="images/unity_linux_build_support.png" |

|||

alt="Linux Build Support" |

|||

width="500" border="10" /> |

|||

</p> |

|||

|

|||

## Windows 사용자 |

|||

Windows에서 환경을 설정하기 위해, [세부 사항](Installation-Windows.md)에 설정 방법에 대해 작성하였습니다. |

|||

Mac과 Linux는 다음 가이드를 확인해주십시오. |

|||

|

|||

## Mac 또는 Unix 사용자 |

|||

|

|||

### ML-Agents Toolkit 저장소 복제 |

|||

|

|||

유니티 설치 후에 ML-Agents Toolkit 깃허브 저장소를 설치하고 싶을 것입니다. |

|||

|

|||

```sh |

|||

git clone https://github.com/Unity-Technologies/ml-agents.git |

|||

``` |

|||

|

|||

`UnitySDK` 하위 디렉토리에는 프로젝트에 추가할 유니티 애셋이 포함되어 있습니다. |

|||

또한 시작하는데 도움이 되는 많은 [예제 환경](Learning-Environment-Examples.md)들이 있습니다. |

|||

|

|||

`ml-agents` 하위 디렉토리에는 유니티 환경과 함게 사용하는 심층 강화학습 트레이너 파이썬 패키지가 포함되어 있습니다. |

|||

|

|||

`ml-agents-envs` 하위 디렉토리에는 `ml-agents` 패키지에 종속되는 유니티의 인터페이스를 위한 파이썬 API가 포함되어 있습니다. |

|||

|

|||

`gym-unity` 하위 디렉토리에는 OpenAI Gym의 인터페이스를 위한 패키지가 포함되어 있습니다. |

|||

|

|||

### 파이썬과 mlagents 패키지 설치 |

|||

|

|||

ML-Agents toolkit을 사용하기 위해 [setup.py file](../ml-agents/setup.py)에 나열된 종속성과 함께 파이썬 3.6이 필요합니다. |

|||

주요 종속성의 일부는 다음을 포함합니다: |

|||

|

|||

- [TensorFlow](Background-TensorFlow.md) (Requires a CPU w/ AVX support) |

|||

- [Jupyter](Background-Jupyter.md) |

|||

|

|||

Python 3.6이 만약 설치되어 있지 않다면, [다운로드](https://www.python.org/downloads/)하고 설치하십시오. |

|||

|

|||

만약 당신의 파이썬 환경이 `pip3`을 포함하지 않는다면, 다음 |

|||

[지시사항](https://packaging.python.org/guides/installing-using-linux-tools/#installing-pip-setuptools-wheel-with-linux-package-managers) |

|||

을 따라서 설치하십시오. |

|||

|

|||

종속성과 `mlagents` 파이썬 패키지를 설치하기 위해 다음 명령어를 실행하십시오: |

|||

|

|||

```sh |

|||

pip3 install mlagents |

|||

``` |

|||

|

|||

이 명령어를 통해 PyPi로 부터(복제된 저장소가 아닌) `ml-agents`가 설치될 것입니다. |

|||

만약 성공적으로 설치를 완료 했다면, `mlagents-learn --help` 명령어를 실행할 수 있을 것입니다. |

|||

명령어를 실행하면 유니티 로고와 `mlagents-learn`에서 사용할 수 있는 명령어 라인 매개변수들을 볼 수 있습니다. |

|||

|

|||

**주의:** |

|||

|

|||

- 현재 Python 3.7 또는 Python 3.5을 지원하지 않습니다. |

|||

- 만약 Anaconda를 사용하고 TensorFlow에 문제가 있다면, 다음 |

|||

[링크](https://www.tensorflow.org/install/pip)에서 Anaconda 환경에서 어떻게 TensorFlow를 설치하는지 확인하십시오. |

|||

### 개발을 위한 설치방법 |

|||

|

|||

만약 `ml-agents` 또는 `ml-agents-envs`를 수정하고 싶다면, PyPi가 아닌 복제된 저장소로 부터 패키지를 설치해야 합니다. |

|||

이를 위해, `ml-agents`와 `ml-agents-envs`를 각각 설치해야 합니다. 저장소의 루트 디렉토리에서 다음 명령어를 실행하십시오: |

|||

|

|||

```sh |

|||

cd ml-agents-envs |

|||

pip3 install -e ./ |

|||

cd .. |

|||

cd ml-agents |

|||

pip3 install -e ./ |

|||

``` |

|||

|

|||

`-e` 플래그를 사용하여 pip를 실행 하면 파이썬 파일을 직접 변경할 수 있고 `mlagents-learn`를 실행할 때 반영됩니다. |

|||

`mlagents` 패키지가 `mlagents_envs`에 의존적이고, 다른 순서로 설치하면 PyPi로 부터 `mlagents_envs`를 |

|||

설치할 수 있기 때문에 이 순서대로 패키지를 설치하는 것은 중요합니다. |

|||

|

|||

## 도커 기반 설치 |

|||

|

|||

만약 ML-Agents를 위해 도커를 사용하고 싶다면, [이 가이드](Using-Docker.md)를 따라하십시오. |

|||

|

|||

## 다음 단계 |

|||

|

|||

[기초 가이드](Basic-Guide.md) 페이지에는 유니티 내에서 ML-Agents toolkit의 설정 및 학습된 모델 실행, |

|||

환경 구축, 학습 방법에 대한 여러 짧은 튜토리얼을 포함하고 있습니다. |

|||

|

|||

## 도움말 |

|||

|

|||

ML-Agents와 관련된 문제가 발생하면 저희의 [FAQ](FAQ.md)와 [제약 사항](Limitations.md) 페이지를 참고해 주십시오. |

|||

만약 문제에 대한 아무것도 찾을 수 없다면 OS, Pythons 버전 및 정확한 오류 메세지와 함께 [이슈 제출](https://github.com/Unity-Technologies/ml-agents/issues)을 해주십시오. |

|||

|

|||

|

|||

## 한글 번역 |

|||

|

|||

해당 문서의 한글 번역은 [장현준 (Hyeonjun Jang)]([https://github.com/janghyeonjun](https://github.com/janghyeonjun))에 의해 진행되었습니다. 내용상 오류나 오탈자가 있는 경우 totok682@naver.com 으로 연락주시면 감사드리겠습니다. |

|||

|

|||

# 모방학습을 통한 에이전트 학습 |

|||

|

|||

에이전트가 시행착오를 통해 스스로 학습하는 것보다 단순히 에이전트가 수행하기를 원하는 행동을 우리가 알려주는 것이 더 직관적일 수 있습니다. 위생병 NPC를 학습하기 위한 [실행 예시](ML-Agents-Overview.md#running-example-training-npc-behaviors) 문서 내용에 대해 생각해보겠습니다. 보상 함수를 이용하여 위생병의 행동을 간접적으로 학습하는 것이 아니라 게임에서 얻어진 관측 (observation)과 게임 컨트롤러를 통해 얻어진 행동들 (actions)의 실제 데이터를 통해 위생병의 행동을 결정하도록 학습합니다. 모방학습 (Imitation Learning)은 실제 플레이를 통해 얻어진 관측과 행동 데이터 쌍을 이용하여 에이전트의 정책을 학습합니다. [비디오 링크](https://youtu.be/kpb8ZkMBFYs). |

|||

|

|||

## 시범 (Demonstration) 데이터 기록 |

|||

|

|||

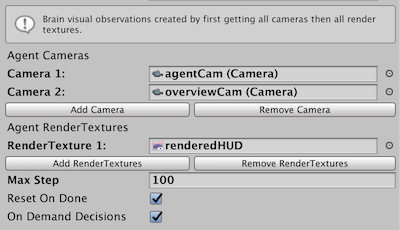

유니티 에디터를 이용하여 에이전트의 플레이를 기록하고 에셋으로 저장하는 것이 가능합니다. 이런 플레이 데이터에는 기록을 진행하는 동안의 관측, 행동 그리고 보상 정보가 포함됩니다. 이것들은 데이터를 통해 관리가 가능하며 Behavioral Cloning과 같은 오프라인 학습에 사용될 수 있습니다. (아래 내용 참고) |

|||

|

|||

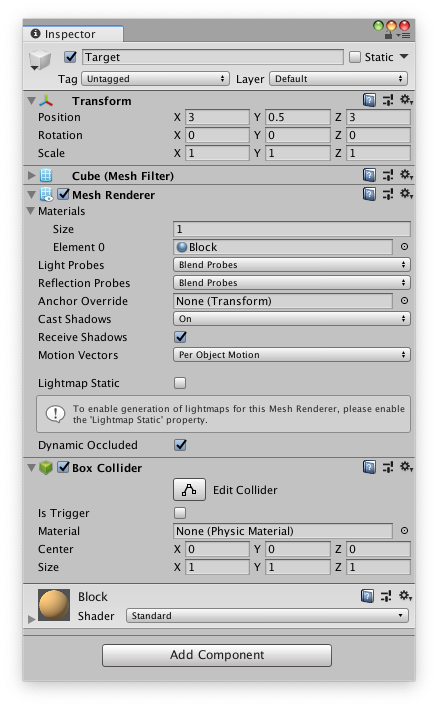

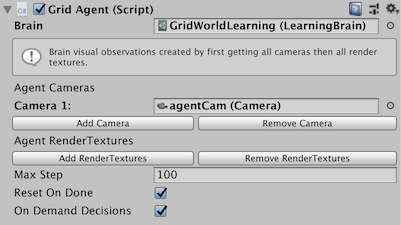

에이전트의 플레이 데이터를 기록하기 위해서는 씬(Scene)에서 `Agent` 컴포넌트를 포함하고 있는 GameObject에 `Demonstration Recorder` 컴포넌트를 추가해주어야 합니다. 일단 추가되고나면 에이전트로부터 플레이 데이터를 기록할 수 있게 됩니다. |

|||

|

|||

<p align="center"> |

|||

<img src="images/demo_component.png" |

|||

alt="BC Teacher Helper" |

|||

width="375" border="10" /> |

|||

</p> |

|||

|

|||

`Record`가 체크되는 경우 씬이 실행되면 데이터가 생성됩니다. 환경의 난이도에 따라 모방학습에 사용하기 위해 몇분에서 몇시간 정도 플레이 데이터를 수집해야합니다. 충분한 데이터가 기록되었으면 유니티 상에서 게임의 실행을 정지합니다. 그렇게 하면 `.demo` 파일이 `Assets/Demonstations` 폴더 내부에 생성됩니다. 이 파일에는 에이전트의 플레이 데이터가 저장되어 있습니다. 이 파일을 클릭하면 인스펙터 상에 데모 파일에 대한 정보를 아래와 같이 알려줍니다. |

|||

|

|||

<p align="center"> |

|||

<img src="images/demo_inspector.png" |

|||

alt="BC Teacher Helper" |

|||

width="375" border="10" /> |

|||

</p> |

|||

|

|||

|

|||

## Behavioral Cloning을 통한 학습 |

|||

|

|||

모방학습을 위한 다양한 알고리즘이 존재하며 모방학습 알고리즘 중 가장 간단한 알고리즘이 Behavioral Cloning 입니다. 이 알고리즘은 마치 이미지 분류를 위한 지도학습 (Supervised Learning)이나 기타 고전적인 머신러닝 기법들처럼 전문가의 플레이로부터 수집된 데이터를 직접적으로 모방하도록 정책 (Policy)을 학습합니다. |

|||

|

|||

|

|||

### 오프라인 학습 |

|||

|

|||

오프라인 Behavioral Cloning에서 우리는 에이전트의 행동을 학습하기 위해 `Demonstration Recorder`를 통해 생성된 `demo` 파일을 데이터 셋으로 이용합니다. |

|||

|

|||

1. 전문가의 플레이 데이터를 모방하도록 학습하는 에이전트 선택 |

|||

2. `Demonstration Recorder`를 이용하여 전문가의 플레이를 기록합니다. (위의 내용 참고) |

|||

앞으로 설명을 위해 이 기록된 파일의 이름을 `AgentRecording.demo`라고 하겠습니다. |

|||

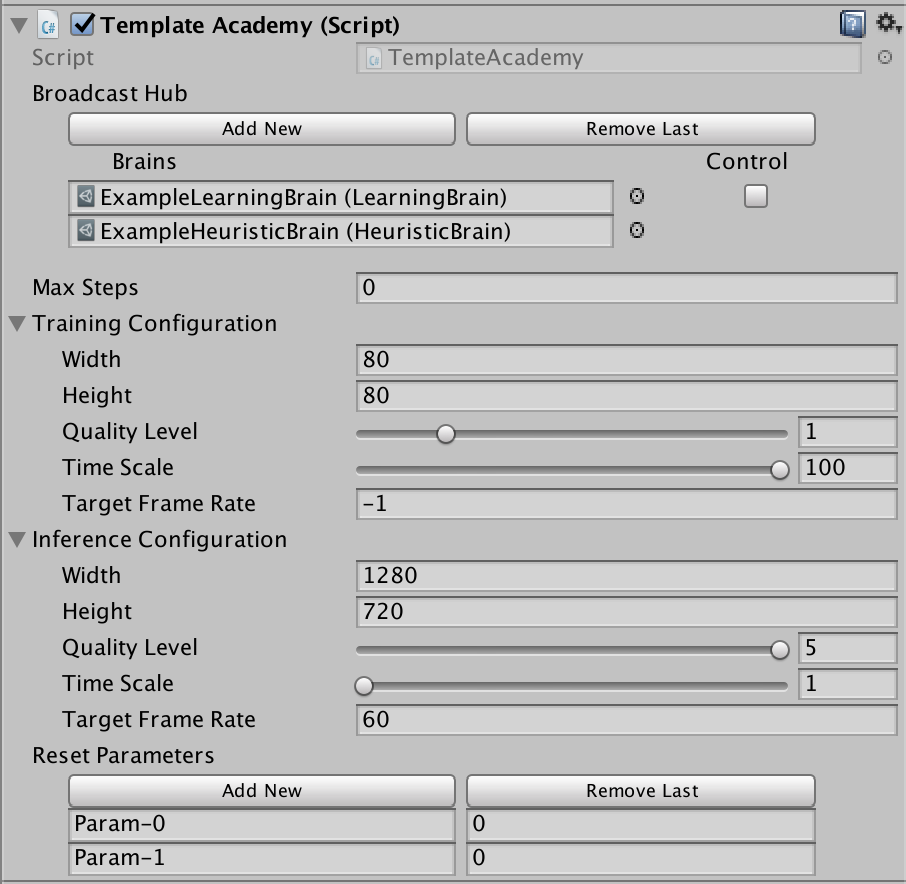

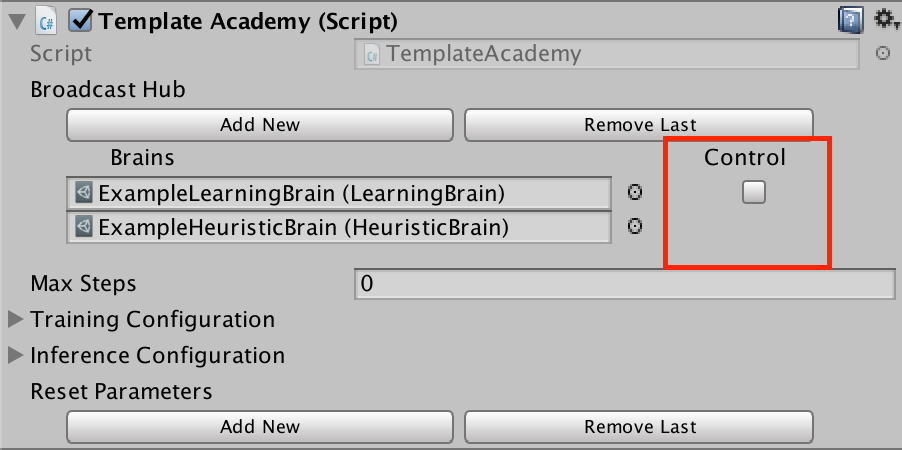

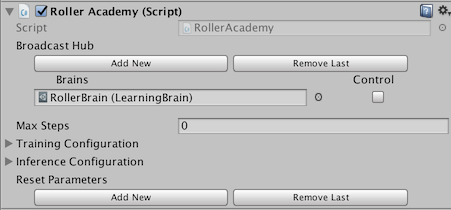

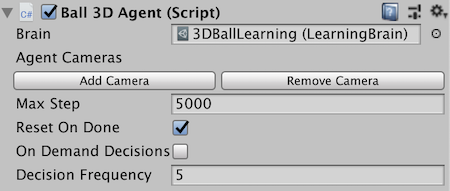

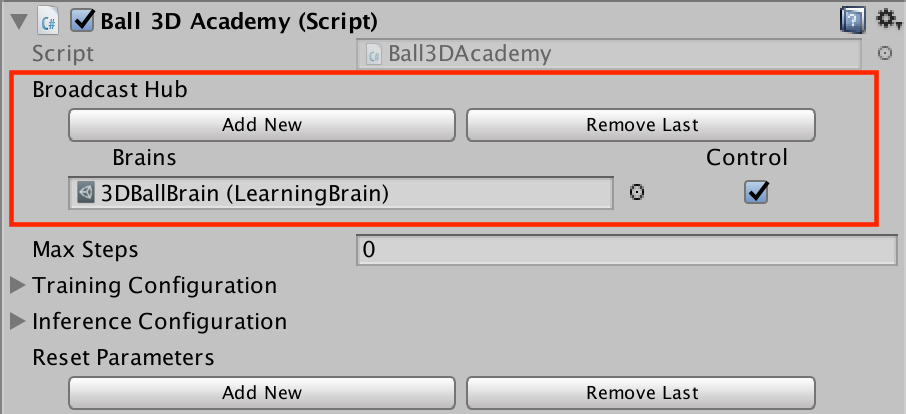

3. 씬을 빌드하고 에이전트에게 러닝 브레인 (Learning Brain)을 할당합니다. 그리고 아카데미의 Broadcast Hub에서 이 브레인의 Control을 체크해줍니다. 브레인에 대한 정보가 필요하시면 다음의 [문서](Learning-Environment-Design-Brains.md)를 참고해주세요. |

|||

4. `config/offline_bc_config.yaml` 파일을 열어줍니다. |

|||

5. `demo_path` 파라미터를 스텝 2에서 기록한 데모 파일의 경로로 수정해줍니다. 이번 예시의 경우 설정된 경로는 다음과 같습니다: `./UnitySDK/Assets/Demonstrations/AgentRecording.demo` |

|||

6. `./config/offline_bc_config.yaml` 을 설정 파라미터로 하는 mlagent-learn을 실행하며 `--run-id` 와 `--train` 을 입력합니다. 빌드된 환경이 standalone으로 컴파일되었거나 에디터에서 train이 생략된 경우 `--env` 파라미터에 빌드된 환경의 경로를 기입해주세요. |

|||

|

|||

7. (선택적) 텐서 보드를 활용하여 학습 성능을 확인해보세요!. |

|||

|

|||

위 방법은 데모 파일을 이용하여 에이전트가 직접적으로 전문가의 행동을 따라하도록 인공신경망을 학습하는 기법입니다. 환경은 학습이 진행되는 동안 에이전트의 성능을 평가하기 위해 실행되며 사용될 것입니다. |

|||

|

|||

### 온라인 학습 |

|||

|

|||

미리 생성된 데모 파일 없이 학습이 진행되는 동안 실시간으로 전문가의 플레이 데이터를 제공하며 에이전트를 학습하는 것도 간으합니다. 이 방법은 다음의 단계를 따라 진행됩니다: |

|||

without pre-recording a demonstration file. The steps to do this are as follows: |

|||

|

|||

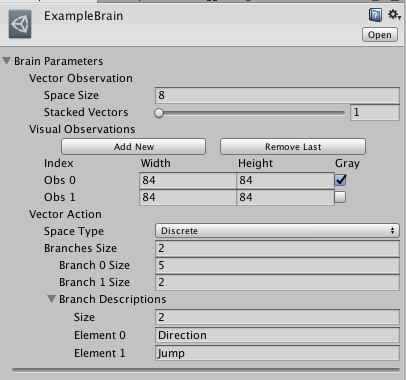

1. 먼저 두개의 브레인들을 생성합니다. 하나는 "선생님"이 될 것이고 하나는 "학생"이 될 것입니다. 이번 예시에서는 두개의 브레인 에셋의 이름을 각각 "Teacher"와 "Student"로 설정할 것입니다. |

|||

2. "Teacher" 브레인은 반드시 **플레이어 브레인 (Player Brain)**이어야 합니다. |

|||

3. "Student" 브레인은 반드시 **러닝 브레인 (Learning Brain)**이어야 합니다. |

|||

4. "Teacher" 브레인과 "Student" 브레인의 파라미터는 에이전트에서 설정한대로 동일하게 설정되어야 합니다. |

|||

5. "Teacher" 브레인과 "Student" 브레인을 아카데미의 `Broadcast Hub`에 추가하고 "Student" 브레인의 `Control` 체크박스에 체크를 해줍니다. |

|||

6. 브레인들을 원하는 에이전트들에게 연결해줍니다. (하나의 에이전트는 선생님으로 설정되어야 하며 적어도 하나의 에이전트는 학생으로 설정되어야 합니다). |

|||

7. `config/online_bc_config.yaml` 파일에서, "Student" 브레인에 대한 항목을 추가해야합니다. `trainer` 파라미터를 `online_bc`로 설정하고 `brain_to_imitate` 파라미터를 선생님 에이전트의 브레인 이름인 "Teacher"로 설정합니다. 추가적으로 각 순간마다 얼마나 많은 학습을 진행할지 결정하는 `batches_per_epoch`를 설정합니다. 에이전트를 더 오랜 기간동안 학습하고 싶은 경우 `max_steps` 값을 증가시켜주세요. |

|||

8. `mlagents-learn config/online_bc_config.yaml |

|||

--train —slow`를 통해 학습과정을 실행하고 화면에 _"Start training by pressing the Play button in the Unity Editor"_ 라는 메세지가 출력되면 유니티의 :arrow_forward: 버튼을 눌러주세요 |

|||

9. 유니티 윈도우 상에서 선생님 브레인을 가진 에이전트를 제어하면서 원하는대로 플레이 데이터를 생성합니다. |

|||

10. 학생 브레인을 가진 에이전트(들)을 살펴보면 선생님 브레인을 가진 에이전트의 플레이와 유사하게 행동하기 시작합니다. |

|||

11. 학생 에이전트들이 원하는대로 행동하게 되면 커멘드 라인에서 `CTL+C`를 눌러서 학습을 중단하십시오. |

|||

12. 생성된 `*.nn` 파일을 Assets 폴더의 하위 폴더인 `TFModels` 폴더로 이동시키고 이 파일을 `러닝` 브레인에 사용하세요. |

|||

|

|||

**BC Teacher Helper** |

|||

|

|||

더 편리한 사용을 위해서, `BC Teacher Helper` 컴포넌트를 선생님 에이전트에 사용할 수 있습니다. |

|||

|

|||

<p align="center"> |

|||

<img src="images/bc_teacher_helper.png" |

|||

alt="BC Teacher Helper" |

|||

width="375" border="10" /> |

|||

</p> |

|||

|

|||

이것을 사용하면 다음과 같은 키보드 단축키를 사용할 수 있습니다: |

|||

|

|||

1. 기록을 시작하거나 중단할 수 있습니다. 이것은 에이전트를 통해 게임을 플레이하되 에이전트가 학습은 되지 않도록 사용할 때 유용합니다. 이것에 대한 기본적인 실행은 키보드의 `R` 버튼을 누르면 됩니다. |

|||

2. 트레이닝 버퍼를 리셋합니다. 이 명령을 통해 에이전트가 최근의 경험에 대한 버퍼를 비우도록 설정합니다. 이것은 에이전트가 빠르게 새로운 행동을 배우게 하고싶을때 사용하면 유용합니다. 버퍼를 리셋하기 위한 기본 명령은 키보드의 `C` 버튼을 누르면 됩니다. |

|||

|

|||

|

|||

|

|||

## 한글 번역 |

|||

|

|||

해당 문서의 한글 번역은 [민규식 (Kyushik Min)]([https://github.com/Kyushik](https://github.com/Kyushik))에 의해 진행되었습니다. 내용상 오류나 오탈자가 있는 경우 kyushikmin@gmail.com 으로 연락주시면 감사드리겠습니다. |

|||

|

|||

# Proximal Policy Optimization를 이용한 학습 |

|||

|

|||

ML-Agents는 [Proximal Policy Optimization (PPO)](https://blog.openai.com/openai-baselines-ppo/) 라는 강화학습 기법을 사용합니다. |

|||

PPO는 에이전트의 관측 (Observation)을 통해 에이전트가 주어진 상태에서 최선의 행동을 선택할 수 있도록 하는 이상적인 함수를 인공신경망을 이용하여 근사하는 기법입니다. ML-agents의 PPO 알고리즘은 텐서플로우로 구현되었으며 별도의 파이썬 프로세스 (소켓 통신을 통해 실행중인 유니티 프로그램과 통신)에서 실행됩니다. |

|||

|

|||

에이전트를 학습하기 위해서 사용자는 에이전트가 최대화하도록 시도하는 보상 시그널을 하나 혹은 그 이상 설정해야합니다. 사용 가능한 보상 시그널들과 관련된 하이퍼파라미터에 대해서는 [보상 시그널](Training-RewardSignals.md) 문서를 참고해주십시오. |

|||

|

|||

`learn.py`를 이용하여 학습 프로그램을 실행하는 방법은 [ML-Agents 학습](Training-ML-Agents.md) 문서를 참고해주십시오. |

|||

|

|||

만약 에이전트에게 기억력을 부여하기 위해 순환 신경망 (Recurrent Neural Network, RNN)을 사용하는 경우, 순환 신경망에 대한 구체적인 학습 방법을 설명하는 [순환 신경망 사용하기](Feature-Memory.md) 문서를 참고해주십시오. |

|||

|

|||

|

|||

만약 에이전트에게 제시된 문제의 난이도를 점차적으로 증가시키며 학습하는 커리큘럼 학습 (Curriculum Learning)을 사용하는 경우 [커리큘럼 학습을 통한 에이전트 학습](Training-Curriculum-Learning.md) 문서를 참고해주십니오. |

|||

|

|||

모방 학습 (Imitation Learning)에 대한 정보를 얻고 싶으시다면 [모방 학습을 통한 에이전트 학습](Training-Imitation-Learning.md) 문서를 참고해주십시오. |

|||

|

|||

|

|||

|

|||

## PPO 학습을 위한 하이퍼파라미터 |

|||

|

|||

강화학습 모델을 성공적으로 학습하기 위해서는 학습과 관련된 하이퍼파라미터 튜닝이 필요합니다. 이 가이드는 기본적인 파라미터들을 이용하여 학습했을 때 사용자가 원하는 성능을 만족하지 못한 경우 파라미터 튜닝을 수행하는 방법에 대해 설명합니다. |

|||

|

|||

## 하이퍼파라미터 |

|||

|

|||

### Reward Signals |

|||

|

|||

강화학습에서 목표는 보상을 최대로 하는 정책 (Policy)을 학습하는 것입니다. 기본적으로 보상은 환경으로부터 주어집니다. 그러나 우리는 다양한 다른 행동을 통해 에이전트에게 보상을 주는 것을 생각해볼 수 있습니다. 예를 들어 에이전트가 새로운 상태를 탐험했을 때 에이전트에게 보상을 줄 수 있습니다. 이런 보상 시그널을 추가하여 학습 과정에 도움을 줄 수도 있습니다. |

|||

|

|||

`reward_signals`는 [보상 시그널](Training-RewardSignals.md)을 정의합니다. ML-Agents는 기본적으로 두개의 보상 시그널을 제공합니다. 하나는 외부 (환경) 보상이며 다른 하나는 호기심 (Curiosity) 보상입니다. 이 호기심 보상은 외부 보상이 희소성을 가지는 환경 (Sparse Extrinsic Reward Environment)에서 더 다양한 탐험을 수행할 수 있도록 도와줍니다. |

|||

|

|||

### Lambda |

|||

|

|||

`lambd` 는 `람다(lambda)` 파라미터를 의미하며 일반화된 이득 추정 (Generalized Advantage Estimate, [GAE]((https://arxiv.org/abs/1506.02438))) 계산에 사용됩니다. 이는 업데이트된 가치를 예측할 때 현재 예측된 가치에 얼마나 의존할지 결정하는 값입니다. 이 값이 낮으면 현재 예측된 가치에 더 의존하는 것을 의미하며 (높은 편향 (bias) 발생 가능), 값이 높으면 환경을 통해 얻은 실제 보상에 더 의존하는 것을 의미합니다 (높은 분산 (variance) 발생 가능). 즉 이 파라미터를 어떻게 선택하냐에 따라 두 특성간에 트레이드오프 (trade-off)가 존재합니다. 또한 이 파라미터를 적절하게 선택하면 더 안정적인 학습이 가능합니다. |

|||

|

|||

일반적인 범위: `0.9` - `0.95` |

|||

|

|||

### Buffer Size |

|||

|

|||

`buffer_size` 는 모델 학습을 시작하기 전 얼마나 많은 경험들(관측, 행동, 보상 등)을 저장할지 결정합니다. **이 값은 `batch_size`의 배수로 설정되어야 합니다.** 일반적으로 큰 `buffer_size`는 더 안정적인 학습을 가능하게 합니다. |

|||

|

|||

일반적인 범위: `2048` - `409600` |

|||

|

|||

### Batch Size |

|||

|

|||

`batch_size` 는 한번의 경사하강(Gradient Descent) 업데이트를 수행할 때 사용할 경험들의 수를 의미합니다. **이 값은 항상 `buffer_size`의 약수로 설정되어야 합니다.** 만약 연속적인 행동 공간 (Continuous Action Space) 환경을 사용하는 경우 이 값은 크게 설정되어야 합니다 (1000의 단위). 만약 이산적인 행동 공간 (Discrete Action Space) 환경을 사용하는 경우 이 값은 더 작게 설정되어야 합니다. (10의 단위). |

|||

|

|||

일반적인 범위 (연속적인 행동): `512` - `5120` |

|||

|

|||

일반적인 범위 (이산적인 행동): `32` - `512` |

|||

|

|||

### Number of Epochs |

|||

|

|||

`num_epoch` 는 경사 하강 (Gradient Descent) 학습 동안 경험 버퍼 (Experience Buffer) 데이터에 대해 학습을 몇번 수행할 지 결정합니다. `batch_size`가 클수록 이 값도 커져야합니다. 이 값을 줄이면 더 안정적인 업데이트가 보장되지만 학습 속도가 느려집니다. |

|||

|

|||

일반적인 범위: `3` - `10` |

|||

|

|||

### Learning Rate |

|||

|

|||

`learning_rate` 는 경사 하강 (Gradient Descent) 학습의 정도를 결정합니다. 학습이 불안정하고 에이전트가 얻는 보상이 증가하지 않는 경우 일반적으로 학습률을 감소시킵니다. |

|||

|

|||

일반적인 범위: `1e-5` - `1e-3` |

|||

|

|||

### Time Horizon |

|||

|

|||

`time_horizon` 은 경험 버퍼 (Experience Buffer)에 저장하기 전 에이전트당 수집할 경험의 스텝 수를 의미합니다. 에피소드가 끝나기 전에 이 한도에 도달하면 가치 평가를 통해 에이전트의 현재 상태로부터 기대되는 전체 보상을 예측합니다. 따라서 이 값의 설정에 따라 덜 편향되지만 분산이 커질수도 있고 (긴 time horizon), 더 편향 (bias)되지만 분산 (variance)이 작아질 수도 있습니다 (짧은 time horizon). 한 에피소드 동안 보상이 빈번하게 발생하는 경우나 에피소드가 엄청나게 긴 경우에는 time horizon 값은 작게 설정하는 것이 이상적입니다. 이 값은 에이전트가 취하는 일련의 행동 내에서 중요한 행동을 모두 포착할 수 있을 만큼 큰 값을 가져야 합니다. |

|||

|

|||

일반적인 범위: `32` - `2048` |

|||

|

|||

### Max Steps |

|||

|

|||

`max_steps` 은 학습 과정 동안 얼마나 많은 시뮬레이션 스텝 (프레임 스킵을 곱한만큼) 을 실행할지 결정합니다. 이 값은 복잡한 문제일수록 크게 설정해야합니다. |

|||

|

|||

일반적인 범위: `5e5` - `1e7` |

|||

|

|||

### Beta |

|||

|

|||

`beta` 는 엔트로피 정규화 (Entropy Regulazation)의 정도를 결정하며 이를 통해 정책을 더 랜덤하게 만들 수 있습니다. 이 값을 통해 에이전트는 학습 동안 액션 공간을 적절하게 탐험할 수 있습니다. 이 값을 증가시키면 에이전트가 더 많이 랜덤 행동을 취하게 됩니다. 엔트로피 (텐서보드를 통해 측정 가능)는 보상이 증가함에 따라 서서히 크기를 감소시켜야합니다. 만약 엔트로피가 너무 빠르게 떨어지면 `beta`를 증가시켜야합니다. 만약 엔트로피가 너무 느리게 떨어지면 `beta`를 감소시켜야 합니다. |

|||

|

|||

일반적인 범위: 1e-4 - 1e-2 |

|||

|

|||

### Epsilon |

|||

|

|||

`epsilon` 은 경사 하강 업데이트 동안 사용하는 이전 정책과 새로운 정책 사이의 비율을 일정 범위의 크기로 제한하는 값입니다. 이 값이 작게 설정되면 더 안정적인 학습이 가능하지만 학습이 느리게 진행될 것입니다. |

|||

|

|||

일반적인 범위: `0.1` - `0.3` |

|||

|

|||

### Normalize |

|||

|

|||

`normalize`는 벡터 관측 (Vector Observation) 입력을 정규화 (Normalization)할지 결정합니다. 이 정규화는 벡터 관측의 이동 평균 및 분산을 기반으로 수행합니다. 정규화는 복잡하고 연속적인 제어 문제에서 도움이 될 수 있지만 단순하고 이산적인 제어 문제에서는 정규화를 사용하는 것이 좋지 않을 수 있습니다. |

|||

|

|||

### Number of Layers |

|||

|

|||

`num_layers` 는 관측 입력 후 혹은 시각적 관측 (Visual Observation)의 CNN 인코딩 이후 몇개의 은닉층 (Hidden Layer)을 사용할지 결정합니다. 간단한 문제에서는 적은 수의 층을 사용하여 빠르고 효율적으로 학습해야합니다. 복잡한 제어 문제에서는 많은 층을 사용할 필요가 있습니다. |

|||

|

|||

일반적인 범위: `1` - `3` |

|||

|

|||

### Hidden Units |

|||

|

|||

`hidden_units` 은 인공신경망의 각 완전연결층 (Fully Connected Layer)에 몇개의 유닛을 사용할지 결정합니다. 최적의 행동이 관측 입력의 간단한 조합으로 결정되는 단순한 문제에 대해서는 이 값을 작게 설정합니다. 최적의 행동이 관측 입력의 복잡한 관계에 의해 결정되는 어려운 문제에 대해서는 이 값을 크게 설정합니다. |

|||

|

|||

일반적인 범위: `32` - `512` |

|||

|

|||

## (선택적) 순환신경망의 하이퍼파라미터 |

|||

|

|||

아래의 하이퍼파라미터들은 `use_recurrent` 이 참(True)으로 결정된 경우에만 사용합니다. |

|||

|

|||

### Sequence Length |

|||

|

|||

`sequence_length` 는 학습 동안 네트워크를 통과하는 연속적인 경험들의 길이를 의미합니다. 에이전트가 긴 시간에 대해 기억해야하는 정보가 있다면 이 값을 충분히 길게 설정해야합니다. 예를 들어 에이전트가 물체의 속도를 기억해야하는 경우 이 값은 작게 설정해도 괜찮습니다. 만약 에이전트가 에피소드 초반에 한번 주어진 정보를 계속 기억해야한다면 이 값을 크게 설정해야 합니다. |

|||

|

|||

일반적인 범위: `4` - `128` |

|||

|

|||

### Memory Size |

|||

|

|||

`memory_size` 는 순환신경망의 은닉 상태(hidden state)를 저장하는데 사용되는 배열의 크기를 의미합니다. 이 값은 반드시 4의 배수로 설정되어야 하며 에이전트가 임무를 성공적으로 완수하기 위해서 기억해야하는 정보의 양에 따라 크기를 조절해야합니다. |

|||

|

|||

일반적인 범위: `64` - `512` |

|||

|

|||

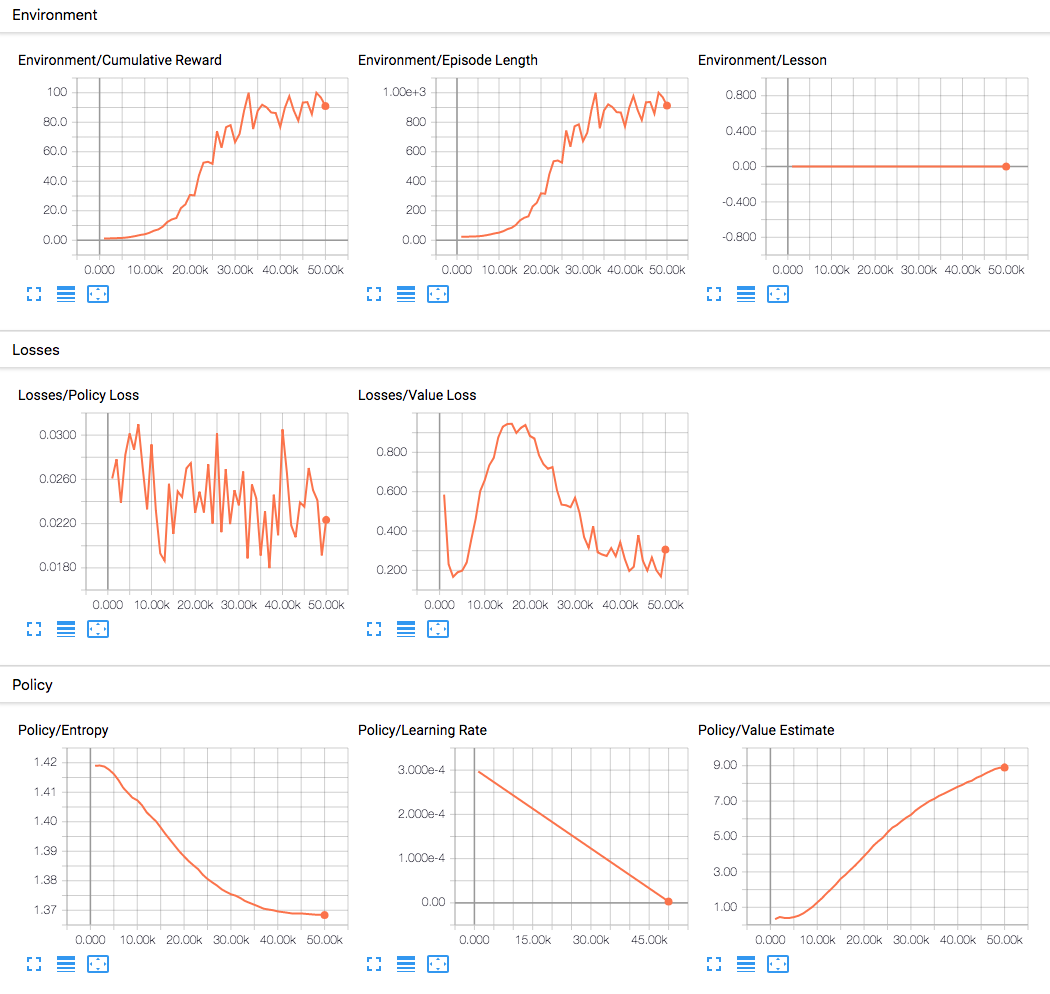

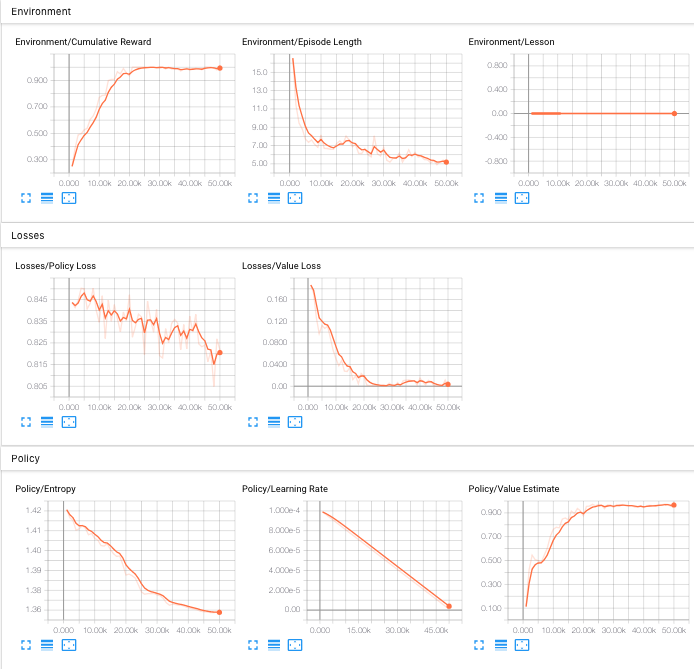

## Training Statistics |

|||

|

|||

학습의 상태를 확인하려면 텐서보드 (TensorBoard)를 사용해야합니다. 텐서보드를 실행하고 사용하는 것에 대한 정보를 알고싶으신 경우 이 [문서](./Getting-Started-with-Balance-Ball.md#observing-training-progress)를 참고해주십시오. |

|||

|

|||

### Cumulative Reward |

|||

|

|||

보상은 일반적으로 지속적으로 증가하는 경향을 가져야합니다. 작은 기복이 발생할수는 있습니다. 문제의 복잡도에 따라 수백만 스텝의 학습이 진행되어도 보상이 증가하지 않을수도 있습니다. |

|||

|

|||

### Entropy |

|||

|

|||

이 값은 브레인이 결정이 얼마나 무작위인지 나타냅니다. 이 값은 학습이 진행되는 동안 지속적으로 감소해야합니다. 만약 이 값이 너무 빠르게 감소하거나 아예 감소하지 않는 경우 `beta`의 크기를 조절해야합니다. (이산적인 행동 공간을 사용하는 경우) |

|||

|

|||

### Learning Rate |

|||

|

|||

이 값은 시간이 지남에 따라 선형적으로 감소합니다. |

|||

|

|||

### Policy Loss |

|||

|

|||

이 값들은 학습이 진행되는 동안 진동합니다. 일반적으로 이 값들은 1보다 작아야합니다. |

|||

|

|||

### Value Estimate |

|||

|

|||

이 값들은 누적 보상이 증가함에 따라 커져야합니다. 이 값들은 주어진 시점에서 에이전트가 스스로 받을 것이라 예측하는 미래의 보상이 얼마나 될것인지를 나타냅니다. |

|||

|

|||

### Value Loss |

|||

|

|||

이 값들은 보상이 증가하면 증가하고 보상이 안정되면 감소합니다. |

|||

|

|||

|

|||

|

|||

## 한글 번역 |

|||

|

|||

해당 문서의 한글 번역은 [민규식 (Kyushik Min)]([https://github.com/Kyushik](https://github.com/Kyushik))에 의해 진행되었습니다. 내용상 오류나 오탈자가 있는 경우 kyushikmin@gmail.com 으로 연락주시면 감사드리겠습니다. |

|||

|

|||

# ML-Agents 용 도커 사용법 |

|||

|

|||

도커를 사용해 추론과 학습을 하고자하는 Windows와 Mac 사용자를 위한 솔루션을 제공합니다. |

|||

이것은 Python과 TensorFlow 설치를 피하고자 하는 분에게 매력적인 옵션이 될 것입니다. 현재 설정은 TensorFlow와 Unity가 _CPU를 통해서만_ |

|||

계산하도록 합니다. 따라서 도커 시뮬레이션은 GPU를 사용하지 않고 시각적 렌더링을 위해 [`Xvfb`](https://en.wikipedia.org/wiki/Xvfb)를 사용합니다. |

|||

`Xvfb`는 `ML-Agents`(또는 다른 응용 프로그램)가 가상으로 렌더링을 할 수 있게하는 유틸리티 입니다. 즉, `ML-Agents`를 실행하는 기계가 GPU를 가지고 있거나 |

|||

디스플레이를 가지고 있다고 가정하지 않습니다. 이것은 카메라 기반의 시각적 관찰 요소가 포함된 환경은 더욱 느려질 수도 있음을 의미합니다. |

|||

|

|||

## 요구사항 |

|||

|

|||

- 유니티 _Linux Build Support_ 컴포넌트 |

|||

- [도커](https://www.docker.com) |

|||

|

|||

## 설치 |

|||

|

|||

- 유니티 인스톨러를 [다운로드](https://unity3d.com/kr/get-unity/download)하고 _Linux Build Support_ 컴포넌트를 추가하십시오. |

|||

|

|||

- 도커가 설치되어 있지 않다면 [다운로드](https://www.docker.com/community-edition#/download)하고 설치 하십시오. |

|||

|

|||

- 호스트 머신과 분리된 환경에서 도커를 실행하기 때문에, 호스트 머신안에 마운트된 디렉토리는 트레이너 환경 설정 파일, |

|||

유니티 실행 파일, 커리큘럼 파일과 TensorFlow 그래프와 같은 데이터를 공유하기위해 사용됩니다. |

|||

이를 위해, 편의상 비어있는 `unity-volume` 디렉토리를 저장소의 루트에 만들었으나, 다른 디렉토리의 사용은 자유롭게 할 수 있습니다. |

|||

이 가이드의 나머지 부분에서는 `unity-volume` 디렉토리가 사용된다고 가정하고 진행됩니다. |

|||

|

|||

## 사용법 |

|||

|

|||

ML-Agents 용 도커 사용에는 세 단계가 포함됩니다.: 특정 플래그를 사용하여 유니티 환경 빌드, 도커 컨테이너 빌드 |

|||

마지막으로, 컨테이너 실행. 만약 ML-Agents 용 유니티 환경 빌드에 익숙하지 않다면, [3D 밸런스 볼 예제와 함께 시작하기](Getting-Started-with-Balance-Ball.md) 가이드를 먼저 읽으십시오. |

|||

|

|||

### 환경 빌드 (옵션) |

|||

|

|||

_학습을 위해 에디터 사용을 원한다면 이 단계를 건너뛸 수 있습니다._ |

|||

|

|||

도커는 일반적으로 호스트 머신과 (리눅스) 커널을 공유하는 컨테이너를 실행하기 때문에, |

|||

유니티 환경은 리눅스 플랫폼이 구축되어야 합니다. 유니티 환경을 빌드할 때, 빌드 세팅 창(Build Settings window)에서 |

|||

다음 옵션을 선택해 주십시오: |

|||

|

|||

- 타겟 플랫폼을 `리눅스`로 설정 (Set the _Target Platform_ to `Linux`) |

|||

- _아키텍처_를 `x86_64'로 설정 (Set the _Architecture_ to `x86_64`) |

|||

- 환경에서 시각적인 관찰을 필요로 하지않는다면, `headless` 옵션을 선택할 수 있습니다 (아래 사진 참조). |

|||

|

|||

`빌드` (Build)를 클릭하고, 환경 이름을 선택하고 (예시: `3DBall`) 출력 디레토리를 `unity-volume`으로 설정하십시오. |

|||

빌드 후에, 파일 `<환경 이름>.x86_64` 와 하위디렉토리 `<환경 이름>_Data/` 가 `unity-volume` 에 생성 되어있는지 확인하십시오. |

|||

|

|||

|

|||

|

|||

### 도커 컨테이너 빌드 |

|||

|

|||

첫 번째, 도커 머신이 시스템에서 작동하는지 확인하십시오. 저장소의 최상단에서 다음 명령어를 호출하여 |

|||

도커 컨테이너를 빌드하십시오: |

|||

|

|||

```sh |

|||

docker build -t <image-name> . |

|||

``` |

|||

|

|||

`<image-name>`을 도커 이미지 이름으로 바꾸십시오, 예시: `balance.ball.v0.1`. |

|||

|

|||

### 도커 컨테이너 실행 |

|||

|

|||

저장소의 최상단에서 다음 명령어를 호출하여 도커 컨테이너를 실행하십시오: |

|||

|

|||

```sh |

|||

docker run --name <container-name> \ |

|||

--mount type=bind,source="$(pwd)"/unity-volume,target=/unity-volume \ |

|||

-p 5005:5005 \ |

|||

<image-name>:latest \ |

|||

--docker-target-name=unity-volume \ |

|||

<trainer-config-file> \ |

|||

--env=<environment-name> \ |

|||

--train \ |

|||

--run-id=<run-id> |

|||

``` |

|||

|

|||

인수(argument) 값 정보: |

|||

|

|||

- `<container-name>` 은 컨테이너를 구분하기위해 사용됩니다 (컨테이너를 인터럽트하거나 종료시킬 때). |

|||

이것은 선택사항이며 설정하지 않았을 경우 도커는 랜덤한 이름을 생성합니다. _도커 이미지를 실행할 때마다 |

|||

고유한 이름을 가져야함에 유의하십시오._ |

|||

- `<image-name>` 컨테이너를 빌드할 때 사용할 image name을 참조합니다. |

|||

- `<environment-name>` __(옵션)__: 리눅스 실행파일과 함께 학습을 할 경우, 인수 값이 실행파일의 이름이 된다. |

|||

에디터에서 학습을 할 경우, `<environment-name>` 인수를 전달하지 말고 유니티에서 _"Start training by pressing |

|||

the Play button in the Unity Editor"_ 메세지가 화면에 표시될 때 :arrow_forward: 버튼을 누르십시오. |

|||

- `source`: 유니티 실행파일을 저장할 호스트 운영체제의 경로를 참조합니다. |

|||

- `target`: 도커가`source` 경로에 이 이름을 가진 디스크로 마운트하도록 합니다. |

|||

- `docker-target-name`: ML-Agents 파이썬 패키지에게 유니티 실행파일을 읽고 그래프를 저장할 수 있는 디스크의 이름을 알려준다. |

|||

**그러므로 `target`과 동일한 값을 가져야 합니다.** |

|||

- `trainer-config-file`, `train`, `run-id`: ML-Agents 인자들은 `mlagents-learn`로 전달됩니다. 트레이너 설정 파일의 이름 `trainer-config-file`, |

|||

알고리즘을 학습하는 `train`, 그리고 각 실험에 고유한 식별자를 태깅하는데 사용되는 `run-id`. |

|||

컨테이너가 파일에 접근할 수 있도록 trainer-config 파일을 `unity-volume` 안에 둘 것을 권장합니다. |

|||

|

|||

`3DBall` 환경 실행파일을 학습하기 위해 다음 명령어가 사용됩니다: |

|||

|

|||

```sh |

|||

docker run --name 3DBallContainer.first.trial \ |

|||

--mount type=bind,source="$(pwd)"/unity-volume,target=/unity-volume \ |

|||

-p 5005:5005 \ |

|||

balance.ball.v0.1:latest 3DBall \ |

|||

--docker-target-name=unity-volume \ |

|||

trainer_config.yaml \ |

|||

--env=3DBall |

|||

--train \ |

|||

--run-id=3dball_first_trial |

|||

``` |

|||

|

|||

도커 마운트에 대한 세부 사항은 도커의 [이 문서](https://docs.docker.com/storage/bind-mounts/)를 참고해 주십시오. |

|||

|

|||

**참고** 도커를 사용해 시각적인 관찰을 포함한 환경을 학습할 경우, 콘테이너를 위해 할당한 도커의 디폴트 메모리를 늘려야할 것입니다. |

|||

예를 들어, [여기](https://docs.docker.com/docker-for-mac/#advanced) Mac 사용자를 위한 도커 지시사항을 봐주십시오. |

|||

|

|||

### 컨테이너 중지 및 상태 저장 |

|||

|

|||

학습 진행 상황에 만족했을 경우, 상태를 저장하는 동안 `Ctrl+C` or `⌘+C` (Mac) 키를 사용하거나 다음 명령어를 통해 도커 컨테이너를 중지할 수 있습니다: |

|||

|

|||

```sh |

|||

docker kill --signal=SIGINT <container-name> |

|||

``` |

|||

|

|||

`<container-name>` 은 `docker run` 명령어에 지정된 컨테이너 이름입니다. 지정하지 않으면 무작위로 생성되며`docker container ls`를 통해 확인할 수 있습니다. |

|||

|

|||

|

|||

## 한글 번역 |

|||

|

|||

해당 문서의 한글 번역은 [장현준 (Hyeonjun Jang)]([https://github.com/janghyeonjun](https://github.com/janghyeonjun))에 의해 진행되었습니다. 내용상 오류나 오탈자가 있는 경우 totok682@naver.com 으로 연락주시면 감사드리겠습니다. |

|||

497

docs/localized/KR/docs/images/3dballhard.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

1001

docs/localized/KR/docs/images/bananaimitation.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

1001

docs/localized/KR/docs/images/image-banner.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

1001

docs/localized/KR/docs/images/running-a-pretrained-model.gif

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

1001

docs/localized/KR/docs/images/walker.png

文件差异内容过多而无法显示

查看文件

文件差异内容过多而无法显示

查看文件

撰写

预览

正在加载...

取消

保存

Reference in new issue